Жахи нейронних мереж. Частина 4.5: Clearview AI та хибні звинувачення

ithitym

ithitym

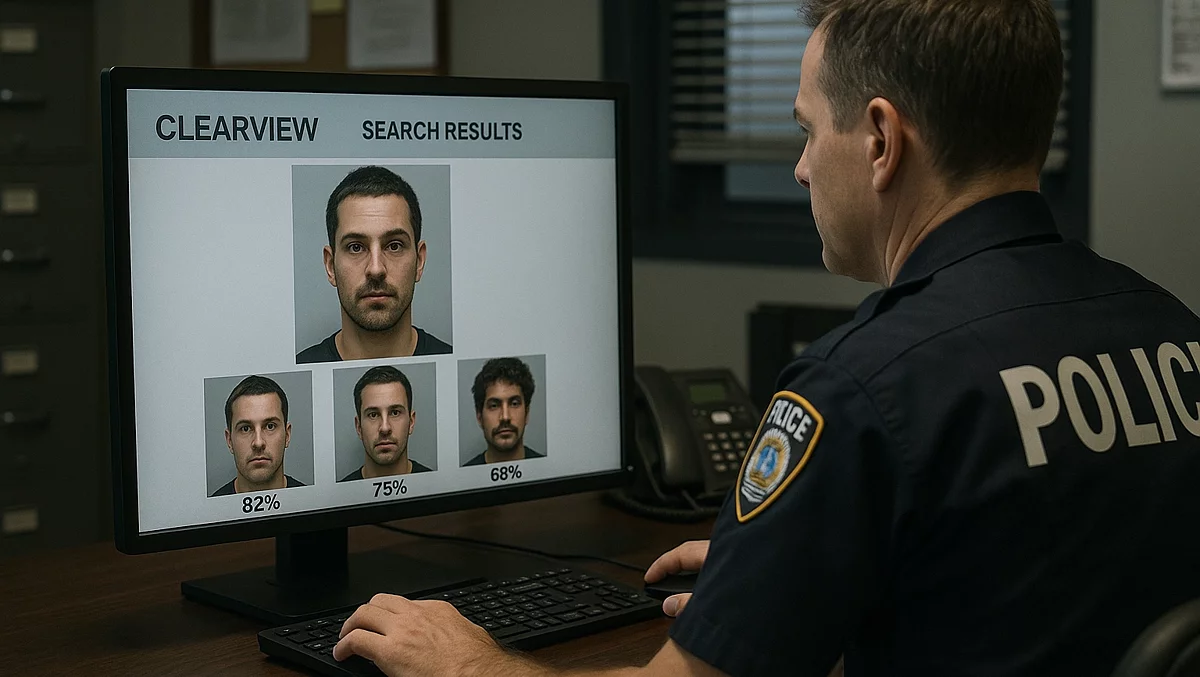

С допомогою розпізнавання облич на базі штучного інтелекту поліція успішно ловить злочинців і рятує людей. Але, як і будь-яка технологія, при неправильному використанні вона може завдати багато шкоди. У цій статті розгляну випадки помилкових арештів, здійснених на основі невірної ідентифікації в програмі розпізнавання облич.

Як випливає з назви, це п'ята стаття в серії. З рештою можете ознайомитися за посиланнями нижче:

Ця частина, в основному, є продовженням попередньої, тому рекомендую з нею ознайомитися.

На всякий випадок коротко нагадаю основні моменти.

Clearview AI — це приватна компанія з розпізнавання облич з обширною базою даних, яка містить більше ніж 50 мільярдів фотографій. Вони були автоматично зібрані з усього інтернету, включаючи Instagram, Facebook, YouTube, Twitter та інші платформи (незважаючи на те, що деякі з них забороняють це робити). Clearview AI надає свою базу і технологію розпізнавання облич на базі штучного інтелекту більш ніж двом тисячам організацій (правоохоронним, в основному) у більш ніж 20 країнах. Серед їхніх клієнтів були університети, мережі супермаркетів і навіть пара ігорних бізнесів.

У попередній частині я згадував випадки, коли Clearview AI допомагала ловити злочинців і рятувати дітей від сексуального насильства, але у цієї технології є і зворотний бік.

На офіційному сайті стверджується, що технологія точна на «99+%» для всіх демографічних груп. Здавалося б, все прекрасно. Є непомильний спосіб виявляти злочинців за фотографіями, які вони ж і опублікували в мережі. Але... чи не боїтеся опинитися серед 1% помилкових результатів? У цій статті йдеться якраз про такі випадки.

Я зупинився на розборі витоку документів, проведеному BuzzFeed News. Окрім аналізу отриманих даних, вони намагалися зв'язатися з організаціями, вказаними серед клієнтів Clearview AI. Хтось заперечував, хтось не був в курсі, що співробітник використовував сервіс, а іноді й зовсім ігнорували запит видання. Але були й ті, хто йшли на контакт. Там досить багато цікавого, але хотілося б звернути увагу на дві відповіді.

Перша відповідь надійшла від департаменту поліції Чикаго. Вони заплатили 49 875 доларів за 2 роки ліцензії на 30 осіб і провели в сервісі більше 1500 пошуків. Но вони використовували це ПЗ як додатковий захід, якщо пошук через DataWorks (внутрішню базу даних, зібрану в Чикаго та його околицях) результатів не дав.

Другим відповіддю є слова капітана поліції Джейсона Ерколе (Jason Ercole) з поліцейського департаменту Сеноії (місто розташоване в штаті Джорджія). Він не став заперечувати, що використовував сервіс, і пояснив свою позицію. За словами Джейсона, спочатку він використовував пробну версію, а потім перейшов на платну. З того часу він здійснив одне успішне ідентифікування підозрюваного у підробці чеків. За його словами, йому не потрібно було проходити навчання або сертифікацію для отримання або використання цього ПЗ (запам'ятайте цей момент, він стане в нагоді).

Також він запевнив, що ніколи не використовував результати збігу як єдине підґрунтя для отримання ордера на арешт. Він впевнений, що це хороший інструмент, якщо використовувати його належним чином і з обережністю.

І це досить здоровий підхід. Зроблю невеликий відступ.

Люди іноді можуть сліпо довіритися нейромережам в якихось не особливо важливих моментах. Наприклад, дізнатися, як правильно перекладається слово, або коли хочуть довести існування Windows 97, щоб скинути згенеровану відповідь у коментарях і витерти співрозмовнику носа.

Але нейромережі можуть допускати помилки, як через галюцинації, так і шляхом неправильних або застарілих даних, на які вони посилаються. Навіть у ChatGPT нижче вікна вводу є рядок «ChatGPT може допускати помилки. Рекомендуємо перевіряти важливу інформацію». Тому не можна просто ввести в промт питання на незнайому тему і скопіювати відповідь, сподіваючись, що чат-бот все перевірив, а не скинув якусь нісенітницю. Перевіряти повинні ви самі. Немає нічого ганебного в використанні нейромереж для пошуку інформації. Але важливо, щоб вони не були єдиним способом пошуку. І не завадило б переходити в видання, на які вона посилається, щоб перепроверити.

Але якщо неправильна відповідь під час повсякденного використання може призвести до неправильного тлумачення слова або до помилки в коментарі, то до чого можуть призвести помилки в більш важливих задачах, таких як розпізнавання облич?

Без вини винуватий

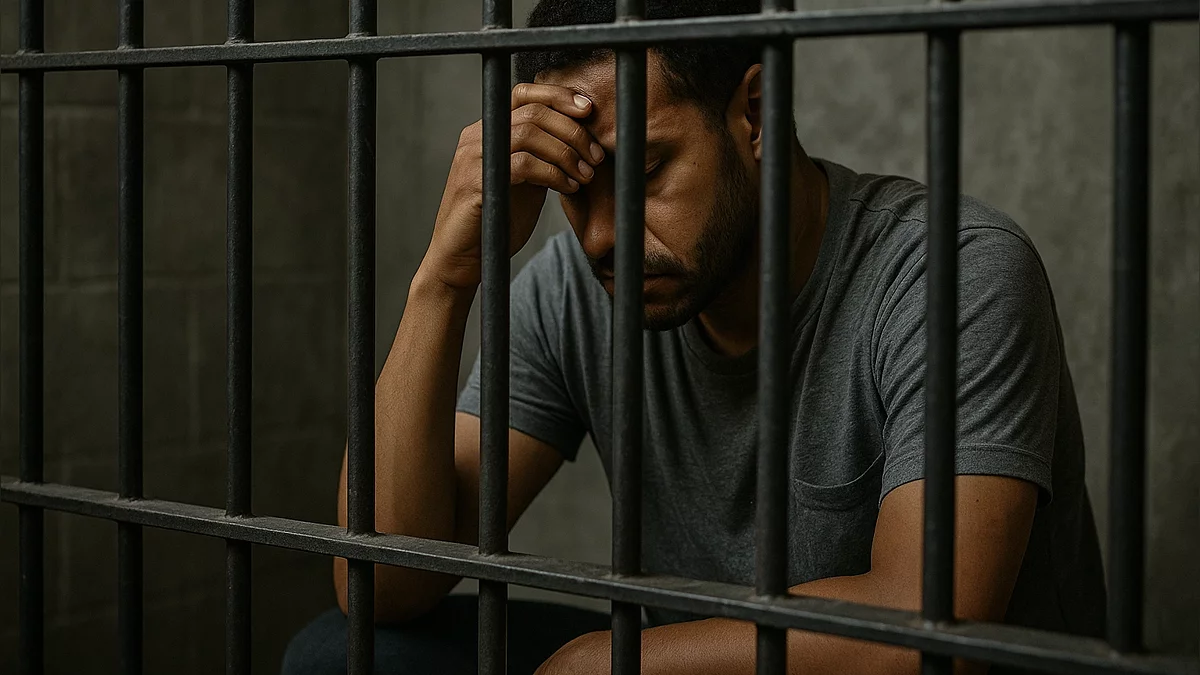

У 2023 році вийшла дуже хороша стаття від The New Yorker, присвячена цій проблемі. Зокрема, в ній згадується про Алонзо Сойера (Alonzo Sawyer), якого обвинувачували в нападі на водія автобуса. З підстав для арешту 50-річного чоловіка було лише те, що його обличчя програма вважала схожим на фото розшукуваного. В день нападу Алонзо гостював з дружиною у невістки, яка живе за 40 хвилин їзди від місця злочину. Він не міг згадати, чи відлучався кудись, але запевняв, що ні в яких конфронтаціях не брав участі. Тим не менш, його затримали і тримали під арештом, поки завдяки зусиллям його дружини не були надані докази його невинуватості. Хоча відпустили відносно швидко, Сойєр був іншої думки.

Він згадує, що, сидячи в камері, розмірковував про те, що якщо його засудять, він залишок днів проведе у в'язниці (стаття, за якою його звинувачували, загрожувала до 25 років в'язниці). Від цих думок було відчуття безпорадності, відчував себе маленькою людиною, загубленою в системі. Якби не дружина, він був готовий визнати провину у злочині, якого не скоював, лише б отримати менш суворе покарання.

Це не перший випадок, коли тільки на підставі збігу в базі людина була помилково звинувачена.

Ніджер Паркс (Nijeer Parks) вийшов з в'язниці в 2016 році і вирішив почати вести чесне життя. Улаштувався клерком в одну компанію, хотів одружитися, будував плани на життя, але в 2019 році був звинувачений у крадіжці з магазину в місті, де ніколи не був. Поліцейські були впевнені, що це він, тільки на підставі результатів пошуку через Clearview AI. Йому загрожувало до 20 років позбавлення волі (минулі злочини, які він відшкодував, були обтяжуючими обставинами). Прокуратура пропонувала йому визнати провину в обмін на 6 років в'язниці без права дострокового звільнення. Паркс з нареченою витратили понад шість тисяч доларів на адвокатів, і він добився звільнення. Хоча він вийшов з в'язниці через 10 днів, ще цілий рік тривали судові тяжби, за підсумками яких суддя відхилив звинувачення проти нього, оскільки, крім збігу в сервісі, ніяких інших доказів не було.

Паркс досі судиться щоб відстояти свої права.

До слова, після цього інциденту поліцейським в Нью-Джерсі заборонили використовувати цей інструмент.

Проблема полягає навіть не в самому ШІ, а в тому, як люди його застосовують. На початку статті згадував капітана поліції, який заявляв, що не вимагалася якась спеціальна підготовка для того, щоб користуватися додатком. І дуже даремно. Недобросовісне використання технології (тим більше без попереднього навчання) може призвести до сумних наслідків.

Одне діло провести за ґратами пару днів або навіть пару тижнів. Але що, якщо помилка, допущена під час використання нейромережі, коштуватиме комусь рік життя, а то й два?

Так було і з 22-річним Крісом Гатліним, який провів 17 місяців за ґратами тільки через збіг у Clearview AI, повідомляє Fox2. Його звинуватили в нападі в метро. Перед його арештом до жертви, 62-річному охоронцю Майклу Фельдману (Michael Feldman), прийшли поліцейські з 6 фотографіями, на одній з яких був «підозрюваний». Через черепно-мозкову травму йому було складно згадати обличчя нападника. Але поліцейські наполягали, щоб він подивився на фото, що він і зробив. Він довго вдивлявся в обличчя і відкидав варіанти, поки не залишилося дві картки, серед яких був і Гатлін. Проте Фельдман спочатку вибрав інше фото, але через запитання поліції змінив своє рішення. Все б так і залишилося, якби не спливла запис з нагрудної камери одного з поліцейських, присутніх при показі знімків. (Запис є в нижченаведеній статті.)

Можна було б подумати, що такі випадки дуже рідкісні, але розслідування Washington Post «Police ignore standards after AI facial recognition matches», показує зворотне. Відомо як мінімум про 8 хибних обвинувачень, але це тільки ті, які отримали розголос. Пошукати інші випадки можна за допомогою Artificial Intelligence Incident Database, яка індексує відомості про інциденти, пов'язані з використанням нейронних мереж. Тепер поговоримо про те, чому так відбувається.

Причини помилок

В лабораторних умовах, з якісними знімками, система працює бездоганно, однак, за заявами Washington Post, не було незалежних перевірок, під час яких якість фото було наближене до «польових» умов. Часто у поліції є тільки нечіткі кадри, за якими розпізнати обличчя стає проблематично.

Наведу приклади фотографій, прикріплених до записів про розшук, зі сторінок поліцейських департаментів у Facebook (один із постів для прикладу).

Іноді системи не справляються з упізнанням, тому що камери не змогли чітко зафіксувати обличчя злочинця. Це може статися через погодні умови, освітлення, кут зору або капюшон з маскою. Так, було і в випадку вбивства генерального директора United Healthcare Брайана Томпсона в центрі Манхеттена. Вбивцю допомогли виявити не алгоритми, а люди. Після того як поліція не змогла пробити фото по базах, вона опублікувала найкращі з отриманих знімків на своїх сторінках. Завдяки цьому поліція отримала відомості про те, що його бачили в «Макдоналдсі» приблизно за 200 миль від Нью-Йорка. Там злочинця і затримали.

Окрім поганої якості знімків, є й інша проблема. Clearview AI часто пропонує кілька збігів і вказує відсоток схожості. Але саме люди обирають, яке з фотографій більше підходить (і використовувати чи знайдене співпадіння як доказ). Іноді поліцейський може бути упередженим у своїх висновках, вважаючи, що система краще розбирається в обличчях, ніж людина.

Не дивно, що й самі поліцейські рідко повідомляють про використання спірної технології (тим самим не даючи можливості оскаржити результати). Це випливає з іншого розслідування Washington Post, проведеного в 2024 році. У ньому журналісти вивчили внутрішні документи деяких департаментів, що використовують розпізнавання облич. Згідно з ними, розпізнавання облич застосовувалося в більш ніж 1000 справах (з 2020 по 2024 рік). Але про їх використання рідко коли писалося в публічних звітах (а іноді й у письмових, через закони деяких штатів щодо персональної інформації).

Помимо розслідувань різних видань, існує проект The Atlas of Surveillance. В ньому зібрана інформація про технології стеження, які використовувалися державними органами. Дані отримують шляхом дослідження відкритих джерел (новини, звіти, плани бюджету тощо). Студенти, викладачі, журналісти та дослідники по крупицях вносять свій внесок у наповнення проекту. Щодо Clearview AI у базі знайшлося 55 підтверджених випадків використання технології в правоохоронних органах.

Небажання розкривати використання програми ще може бути пов'язане з тим, що вже не вперше в суді результати збігів відхиляють як докази. Окрім раніше згаданого випадку в 2020 році, в січні цього року (2025, якщо статтю читають у майбутньому), суддя відхилив результат розпізнавання осіб у справі про вбивство. За його словами, відомостей анонімного джерела та збігів у програмі недостатньо для обвинувачення. Тим більше, у ліцензійних документах Clearview AI чітко сказано, що його результати не можна використовувати в суді, в тому числі як підставу для ордера на арешт. Там багато чого цікавого сказано, але якщо узагальнити, то «Якщо що, система може помилятися. Ми не несемо відповідальності. Не посилайтеся на нас у суді».

Післяслово

Якось і сказати особливо нічого. Дико, що на основі результатів програми людині можуть зруйнувати життя. Сподіваюсь, цих випадків з роками буде менше. Хотілося б вірити...

Ну а на цьому все. Стаття вийшла коротка, але, сподіваюся, інформативна.

Допис створений користувачем

Кожен може створювати пости на VGTimes, це дуже просто - спробуйте!-

![]() ТОП-30 найскладніших ігор — вам буде боляче

ТОП-30 найскладніших ігор — вам буде боляче -

![]() ТОП-30: найкращі кооперативні ігри для PS4 та PS5 — у що пограти з друзями на одній консолі

ТОП-30: найкращі кооперативні ігри для PS4 та PS5 — у що пограти з друзями на одній консолі -

![]() Жахи нейронних мереж. Частина 1: Нейромережі та авторське право

Жахи нейронних мереж. Частина 1: Нейромережі та авторське право -

![]() Жахи нейронних мереж. Частина 2: На яких ваших даних навчаються нейромережі

Жахи нейронних мереж. Частина 2: На яких ваших даних навчаються нейромережі -

![]() Жахи нейронних мереж. Частина 3: Як зробити шапочку з фольги чи варто остерігатися ШІ?

Жахи нейронних мереж. Частина 3: Як зробити шапочку з фольги чи варто остерігатися ШІ? -

![]() Жахи нейронних мереж. Частина 4: Генерація та розпізнавання облич

Жахи нейронних мереж. Частина 4: Генерація та розпізнавання облич